Wie aktuelle KI-Tools im Bereich Video genutzt werden können, demonstriert ein experimenteller, kurzer Beispielclip des Designers Nick St. Pierre schön. Er nutzte bei der Produktion gleich mehrere verschiedene KI-Tools, und zwar ChatGPT, die Bild-KI Midjourney sowie das (bislang nur per geschlossener Beta) zugängliche Runway Gen 1 und die Musik-KI Boomy.

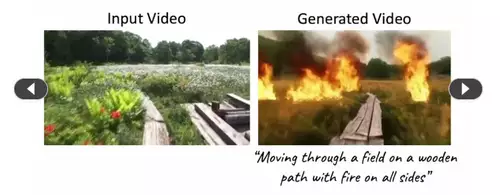

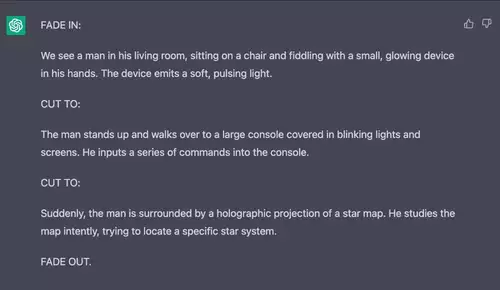

Netterweise erläutert er in einem Twitterthread, den wir hier wiedergeben wollen, wie er die unterschiedlichen KIs im Zusammenspiel einsetzt. Am Anfang wurde das "Drehbuch" per ChatGPT entwickelt. Die Aufgabenstellung lautete "Schreibe ein Drehbuch für ein 9-Sekunden-Video, das aus drei 3-Sekunden-Clips besteht. Die Geschichte sollte einen Mann in seinem Wohnzimmer zeigen und ein Science-Fiction-Thema haben."

Dann wurde ein Referenzbild mittels der Bild-KI Midjourney generiert, um eine Vorlage für den angestrebten visuellen Look und Feel zu produzieren, der dann per Styletransfer auf das ganze Video angewendet werden sollte. Das zugehörige Prompt lautete übersetzt "sci-fi film still, medium shot, zentriert, Seitenansicht, ein Mann sitzt auf einem Stuhl, hält eine leuchtende Kugel in den Händen, Wohnzimmer, New York, 4K --ar 16:9".

Im nächsten Schritt filmte St Pierre mit seinem iPhone dann ganz grob nachgestellt die im Drehbuch beschriebenen Szenen. Um den Styletransfer zu erleichtern, versuchte er die Pose des Midjourney Bildes nachzustellen. Das eigene Video fungiert dabei als Referenz zur Generierung des KI-Videos, ähnlich wie es bei der Bildgenerierung per Stable Diffusion ein Beispielbild mittels ControlNet genutzt wird, um die Bildkomposition grob zu definieren und so eine relativ exakte Umsetzung von ganz bestimmten Anordnungen im Raum oder Posen zu ermöglichen.

Dieser selbst gedrehte Clip diente dann zusammen mit dem Bild aus Midjourney als Grundlage für den Transfer des Bildstiles auf das gesamte Video mithilfe der Runway Gen 1 Video-KI der Macher von Stable Diffusion. Alternativ könnte der neue Bildstil auch per Textprompt beschrieben werden, aber das Referenzbild gibt eine feinere Kontrolle - zumindest wenn man nicht genügend Erfahrung besitzt, um das gewünschte Ziel in Midjourney mittels des richtigen Prompts zu erreichen.

Das selbst gedrehte Referenzvideo:

Daraufhin wurden in einem nächsten Schritt die drei einzelnen Clips in iMovie aneinandergefügt. Dann fehlte nur noch der Soundtrack - diesen erzeugte St Pierre mit Hilfe der Sound-KI Boomy, welche Musik anhand eines vom User festgelegten Stils und Stimmung generiert. Als letztes musste nur noch die Musik mit dem Video kombiniert und das Video exportiert werden - fertig war der Clip. Das Ganze dauerte rund 3 Stunden.

Natürlich ist der kleine Clip nur ein Proof-of-Concept, der zeigen will, wie unterschiedliche KI Tools in einer echten Filmproduktion genutzt werden könnten, wenn die Qualität der per KI generierten Resultate ausreichend gut ist. Bei einer echten Clip-Produktion würde natürlich auch mehr Zeit in das Feintuning der Resulate investiert werden, um einen konsistenten Look zu erzielen.

Je nach dem verwendeten KI-Tool wird es noch mehr oder weniger lange dauern, bis es auf Anhieb produktionsreife Ergebnisse liefert. Aber wie schnell die Entwicklung bei KI-Tools momentan voranschreitet, läßt sich schön an diesem Vergleich des Outputs der verschiedenen Versionen der Bild-KI Midjourney in nur einem Jahr sehen - die Video-KIs werden sich wohl ähnlich schnell verbessern:

Video ganz per KI generiert

Sehr bald wird es aber auch möglich sein, zum Beispiel per Runway Gen2, solche Szenen alleine per Textbeschreibung zu generieren, ganz so wie dies bei den Bild-KIs jetzt schon funktioniert. Allerdings hat die Arbeit mit eigenen Clips als Vorlage den Vorteil, eine bessere Kontrolle über den Output zu bekommen, so können z.B. Posen, Mimiken oder Anordnungen im Raum per Clip vorskizziert werden und dann per Styletransfer mit einem ganz speziellen Look versehen werden.